#1520

Es posible que una 3080 envejezca mejor en ciertos escenarios incluso con el handicap de los 10gb, quizá no para juegos modeados, pero en una mala aunque la VRAM colapsará tienes la opción de bajar detalles/resolución y un posible boost, mientras que lo ofrece AMD es una incógnita.

A saber. Llevo todo el día dándole al tema de la vram mirando cosas para vr, y ojito ojito que ahora sí tengo miedito con las 10 gb de la 3080. porque me están llamando mucho las gafas hp reverb g2 2160 x 2160 LCD panels per eye, eso es una animalada de resolución equivalente a 4k, y por lo visto no es 4k doble como creía, sino algo más de 4k, no me quedó todavía claro pero bueno, sigue siendo una animalada.

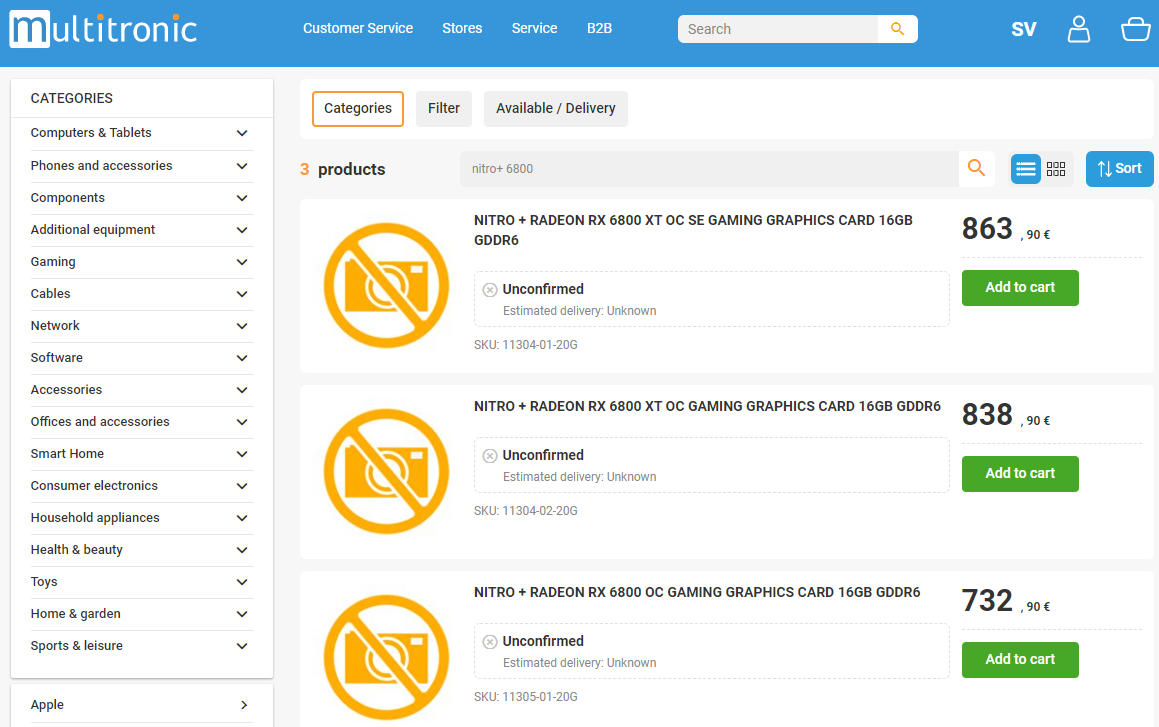

Por lo que he visto la 3080 parece que ahora se podría defender con juegos como half life alyx en cuanto a vram, pero no se no se, me gustaría saber cómo irían esas gafas con un 6800xt, lo del oc en esas gráficas puede ser muy determinante. Si no fuera porque es la 3080 tuf oc la que tengo ya instalada lo tendría más claro... estoy ahora en un sin vivir que no se qué hacer si me decanto ya por AMD tengo que devolver sí o sí en unos días la 3080 hasta el 22 de noviembre tengo de máximo para hacerlo, y si lo hago para pillar AMD lo haría a ciegas sin saber qué me deparará realmente, a no ser que salga de dudas solo mirando las reviews en apenas un día para poder tener oportunidad de pillar una y me huele que los análisis van a ser una guerra sucia y no creo que salgan reviews y benchmark para vr con esas resoluciones con la 6800xt en los primeros días, que es de lo que estoy ahora mismo más preocupado, ya que no solo me voy a mover con mi pantalla a 2k 144hz sino a más resoluciones y a saber qué rendimiento habrá en futuros títulos y claro, aunque pueda uno decir, "pues bajas texturas de épico o ultra a muy alta o alta en 4k y a seguir viviendo..." también también, si me quedo con la 3080 pues en algún título seguro que lo tendré que hacer en un tiempo si quiero llegar a juegos vr a 90 fps estables a esas resoluciones.

Y lo peor de todo es que si voy con AMD y luego me arrepiento porque no logro pillar una, o si la pillo la gráfica no llega, se retrasa, se cancela y toda la puta ruina del stock pandémico me voy a cagar en la puta cien veces después de haber tenido instalada una 3080 tuf oc.

También puedo hacer la cabronada máxima, poner a la venta la 3080 por 950, y cuando la vendiera pillar una de AMD a otro especulador también por otro dineral por lo que la misma cabronada se volvería contra mí y estaría en paz con el universo